Au moment où la généralisation du Cloud est LE phénomène majeur qui touche toutes les couches du marché IT, on est en droit de se demander comment va évoluer l’industrie informatique qui est ainsi remise en cause dans ses structures. En effet, avec l’envol des GAFAM, l’industrie informatique s’est retrouvée dominée par un groupe d’acteurs tout à fait inhabituels.

Certes, ce n’est pas la première fois dans son histoire qu’un groupe leader est remplacé par un autre. Dans un premier temps (les années 60), l’industrie était articulée autour des constructeurs de mainframes, eux-mêmes en nombre restreint. Puis, tout le secteur de la mini-informatique a été secoué en profondeur par la généralisation de la micro-informatique. La vague PC qui a suivi a provoqué l’émergence d’acteurs plus petits et plus nombreux.

Aujourd’hui, nouvelle distribution des cartes : on passe de la vente de systèmes (qui avaient cours depuis plus de quarante ans !) à la vente de services (oui, les applications prêtes à l’emploi dans le Cloud sont bien des services) et toute l’industrie en est (très) impactée. Nous allons passer en revue ensemble les conséquences et les prolongements probables de ce tournant…

Consolidation des perdants

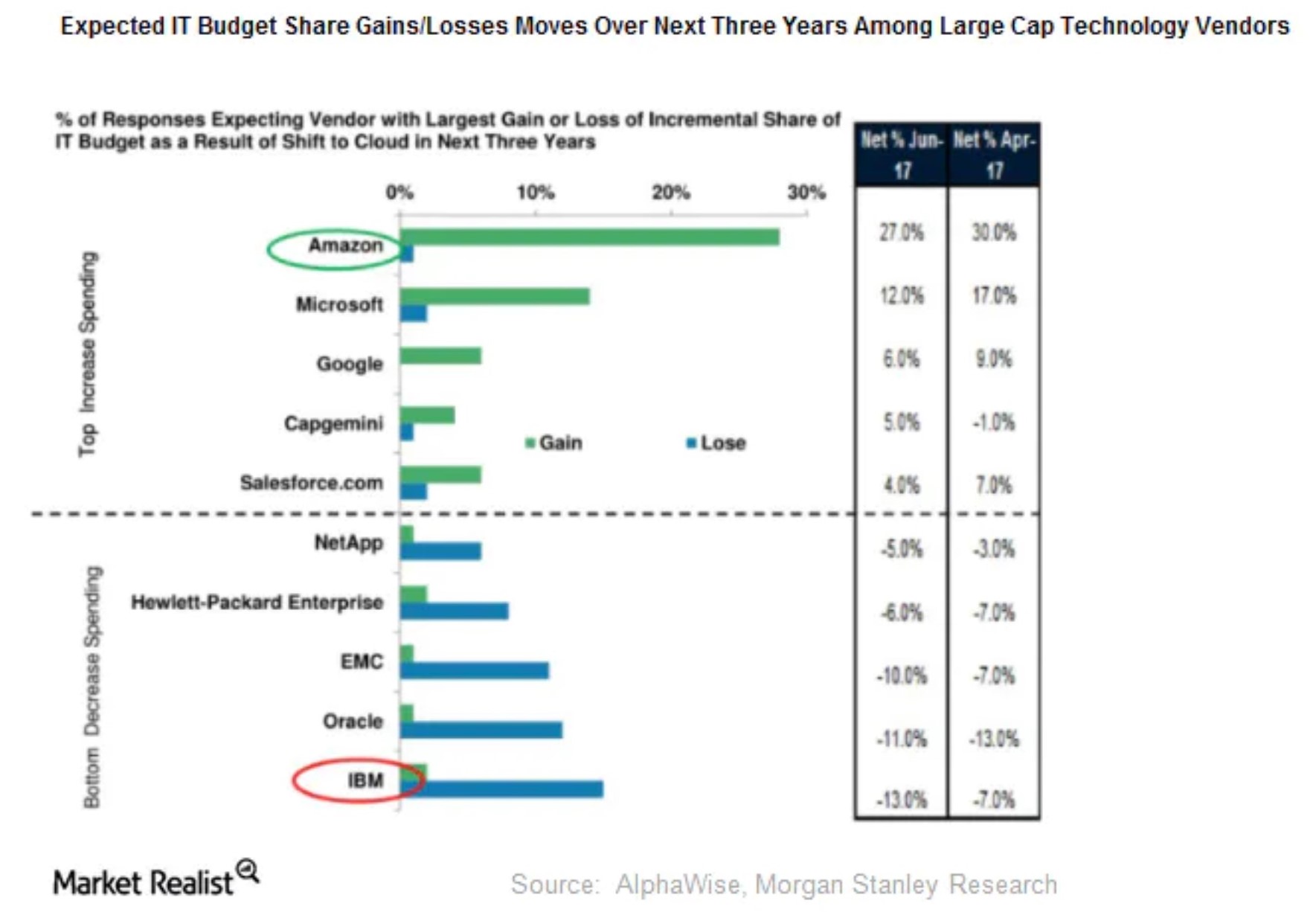

La première conséquence est évidente : les perdants de l’ère du Cloud vont se regrouper entre eux (du moins, ceux qui auront encore assez de valeur pour le faire). Depuis quelques mois, on parle beaucoup d’un rapprochement entre Xerox et HP même si le management de cette dernière n’y est pas favorable pour le moment (peut-être suffira-t-il que l’offre financière de Xerox soit à la hauteur…). Cette fusion peut ne pas aboutir mais la tendance est bien là : les anciens leaders du marché sont tous confrontés à une double contrainte… D’un côté, leurs résultats sont en baisse (par exemple, depuis 2011, IBM a perdu 30 milliards de dollars de revenus, soit près de 30% de son chiffre d’affaires) et de l’autre, les investissements nécessaires pour rester dans la course sont importants (si vous voulez vous faire une vraie place dans le marché du cloud aujourd’hui, le ticket d’entrée est plutôt élevé !).

Quand la croissance n’est plus là, la logique financière prend le dessus et c’est ainsi qu’on se retrouve à imaginer des rapprochements qui auraient parus absurdes il n’y a pas si longtemps.

Laissons de côté Xerox et HP et penchons-nous sur les cas d’Oracle et de SAP… une fusion entre les deux géants du logiciel (afin de profiter de l’effet de taille pour tenter d’enrayer ou, au moins, de ralentir leur déclin respectif) pourrait avoir du sens prochainement !

En effet, ces deux-là font aussi partie des “perdants du cloud” car ils ont tardé à se tourner vers la nouvelle tendance, préférant exploiter jusqu’au bout leurs lucratives activités habituelles. Plus longtemps vous résistez au changement et plus ce dernier est brutal quand il s’impose finalement à vous…

Bien entendu, imaginer que SAP et Oracle fusionnent (ou même que l’un rachète l’autre) semble bien audacieux pour le moment. Mais on a déjà eu des surprises encore plus grandes récemment (comme le rachat de Red Hat par IBM, il y a un peu plus d’un an) et cette fusion n’est pas si “tirée par les cheveux” dès qu’on commence à y songer.

Migration de la production en Asie

Autre tendance lourde, la fabrication se fait de plus en plus souvent en Asie désormais. Historiquement, l’industrie informatique “matérielle” a toujours reposé sur deux pôles : conception et fabrication. Et jusque dans les années 90, les deux se faisaient principalement sur le territoire américain (et surtout en Californie) mais c’est à une véritable migration de masse à laquelle nous assistons depuis en direction de l’Asie. Les disques durs sont majoritairement fabriqués en Thaïlande, les smartphones en Corée du Sud et à Taïwan, les composants, les PC et les Laptops à Taïwan et en Chine. Apple est le porte-drapeau de cette tendance “fabless” : sans Samsung et Foxconn, la production de la firme à la pomme tomberait vite à zéro (comme on peut en avoir actuellement une “preview” avec la crise du coronavirus). Même IBM qui privilégiait le “fait à la maison” (selon le bon vieux principe de l’intégration verticale cher à Big Blue) a de plus en plus recours aux sous-traitants chinois et taïwanais.

Et ce n’est pas seulement la fabrication de masse qui s’est installée (durablement ?) en Asie, une certaine forme d’excellence y règne aussi désormais. Quand TSMC (un gros fabricant de composants électroniques) est passé à la gravure à 7 nanomètres alors qu’Intel n’avait pas encore réussi à être opérationnel avec la gravure à 10 nanomètres, beaucoup d’experts n’en revenaient pas (voir à ce propos notre chronique sur ce sujet à https://www.redsen.com/fr/inspired/tendances-decryptees/le-declin-dintel-est-amorce-par-tsmc). Que le taïwanais TSMC puisse faire mieux que le géant Intel, leader technique depuis des décennies, paraissait tout simplement incroyable. Pourtant, il va falloir s’y habituer : TSMC est désormais devant Intel en matière de fabrication de pointe.

Le cloud triomphe, partout

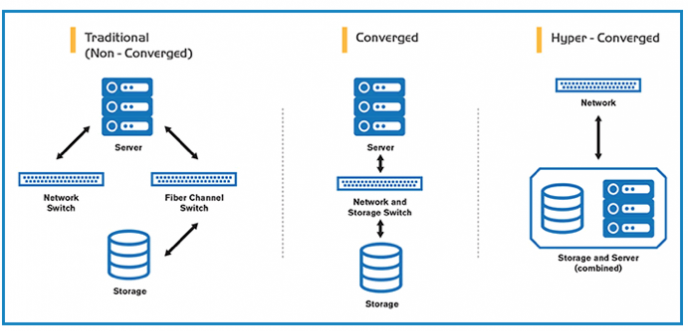

Revenons rapidement sur le “mouvement tectonique” principal : la généralisation du recours au Cloud… Aujourd’hui, le triomphe du Cloud est une évidence qui est confirmée par de nombreux signaux. Même la notion d’hyperconvergence qui permet de virtualiser complètement un site informatique doit être prise comme un élément de plus en faveur du cloud. En effet, une fois virtualisés sur site, les systèmes hérités (legacy systems) sont plus faciles à migrer dans le cloud sur des plateformes standards et moins coûteuses. Cette poussée supplémentaire en faveur des logiciels de virtualisation peut être considérée comme un élément de plus qui confirme le triomphe du cloud sur tous les fronts.

Des systèmes aux services

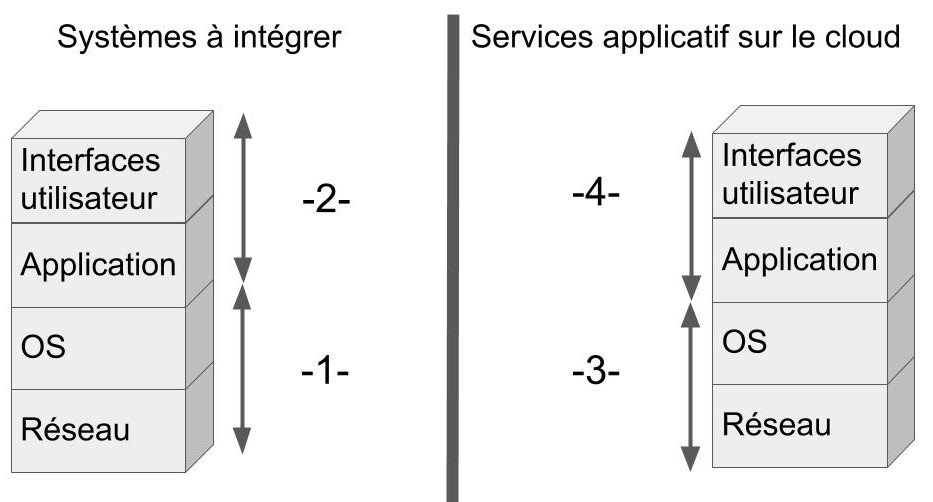

Ce triomphe du cloud a été vécu comme une immense secousse par les acteurs dominants traditionnels et installés depuis des décennies. On peut résumer cette secousse majeure par le passage de la vente de systèmes à la vente de services. Lors des décennies précédentes, les grands acteurs de l’informatique vous vendaient des systèmes à intégrer et il fallait un certain niveau de compétences techniques pour en tirer parti (d’où la nécessité de disposer d’un personnel avec un haut niveau de technicité). Ces constructeurs et éditeurs s’adressaient donc à des clients dont la compétence technique était primordiale, la compréhension des attentes des utilisateurs était secondaire.

Ces utilisateurs devaient se contenter de ce que cette alliance de circonstances entre les grands acteurs et les techniciens des DSI mettaient à leur disposition. Si cela convenait, tant mieux, si cela était médiocre, il fallait patienter en espérant que la prochaine génération de systèmes serait mieux adaptée…

Des utilisateurs mieux pris en compte, progressivement

Cette situation peu satisfaisante a commencé à évoluer, un peu, avec la vague des PC qui demandaient moins de compétences techniques pour les mettre en place et dont les logiciels étaient un peu plus orientés en faveur de la satisfaction des utilisateurs finaux.

Le Web apporta une nouvelle poussée dans la direction des utilisateurs avec un premier effort (nécessaire !) en matière d’ergonomie. Ensuite, la généralisation du mobile a confirmé la nécessité de soigner l’interface utilisateur dans toutes ses dimensions.

Mais c’est surtout avec la montée du Cloud que les choses ont vraiment changé, en profondeur. Avec des acteurs comme Salesforce.com (par exemple), vous n’achetiez plus un système à intégrer mais une application à utiliser directement, quasiment sans délai ni personnalisation, une grande première dans les pratiques et même les mentalités des DSI.

Ce n’était pas une nuance subtile mais bien un changement radical d’approche.

La “face obscure” a changé de côté

Auparavant, les systèmes vous étaient vendus (quasiment “en kit”) sans que le vendeur ne se préoccupe de ce que vous alliez en faire sur le plan applicatif. Avec les services sur le Cloud, c’est tout le contraire : la finalité est très claire, ce sont les couches inférieures qui sont plus obscures. Quand vous choisissez une solution basée sur le cloud, vous ne connaissez pas le détail des couches techniques impliquées et vous ne pouvez intervenir sur ce plan. On peut donc dire que l’obscurité a changé de côté mais est-ce un mal ?

Après tout, peu nous importe les couches systèmes utilisées par AWS du moment que ça marche et que ça reste abordable…

-2- Les couches applicatives qui sont à définir par les clients et laissées de côté par les vendeurs de systèmes.

-3- Les couches systèmes du Cloud, invisibles et inaccessibles aux clients.

-4- Les couches applicatives définies par les fournisseurs du Cloud et qui sont utilisables telle quelles ou, au mieux, configurables par les clients.

Essor de l’Open Source sur les couches techniques

Certains pourraient trouver cette position naïve voire dangereuse mais il s’avère qu’une autre tendance lourde est en train de la rendre acceptable : il s’agit de la montée de l’Open Source sur les couches techniques.

L’Open Source a clairement échoué, de multiples fois, à s’imposer sur le poste de travail lors de ces vingt dernières années. Mais, en revanche, c’est une tout autre situation côté serveurs et réseaux.

Déjà, il faut réaliser que toute l’infrastructure de l’Internet repose sur des projets Open Source et non, il ne s’agit pas seulement du traditionnel et bien connu empilement du serveur LAMP (Linux, Apache, MySQL et PHP). En effet, Bind (DNS) et DHCP reposent sur des projets Open Source gérés par l’ISC (Internet Systems Consortium). Sans eux, rien ne fonctionne !

Même dans l’environnement Cloud, Docker et Kubernetes (pour ne citer qu’eux) sont des projets Open Source. La (re)montée de ce mouvement de fond n’a pas échappé aux principaux acteurs puisque Microsoft a mis la main sur Github alors qu’IBM achetait Red Hat (très cher !). Nous constatons donc une forte poussée des projets Open Source dans le domaine des logiciels d’infrastructure.

Les composants de l’IOT sont modulaires et s’appuient sur des standards

L’Open Source ne progresse pas seulement dans les projets logiciels, c’est également le cas des projets matériels en particulier dans l’IOT. Les composants IOT étant naturellement modulaires, il n’est donc pas surprenant de voir leurs concepteurs adopter une approche ouverte et standard plutôt que fermée et propriétaire.

C’est ainsi que l’IOT se révèle être un “terreau” particulièrement favorable pour des projets Open Source de toutes natures (y compris dans le domaine matériel) : je pense à Arduino et à ThingsBoard en particulier.

Cependant, il ne faudra pas se bercer d’illusions à propos de cette renaissance et de ce nouvel essor de l’Open Source. Si ces vingt dernières années nous ont appris quelque chose, c’est que tous les projets qui adoptent cette démarche ne survivent pas forcément. Pour qu’un projet Open Source survive et progresse, il lui faut de l’audience et des contributeurs, beaucoup de contributeurs.

Les personnels sont moins techniques et plus orientés applicatifs

Or, une tendance dont on ne parle pas beaucoup est que le personnel informatique, dans sa majorité, est en train d’évoluer vers des rôles moins techniques. Et donc, cette évolution s’accompagne d’une perte de compétences. Oui, l’informatique concerne de plus en plus de monde et ceci se confirme décennie après décennie. Mais, même si les programmeurs “full stack” sont plus nombreux que jamais, proportionnellement leur part tend désormais à se réduire. Les premiers à être affectés par cette tendances pourraient être les ingénieurs systèmes. Avec le cloud, leurs interventions sont moins nécessaires et, quand elles le sont, moins “profondes” et demandent moins de compétences pointues. Ce n’est pas la première fois qu’on assiste ainsi à un “déclassement” d’une catégorie de personnel technique. Avec l’amoindrissement du batch, ce sont les pupitreurs qui se sont réduits (je réalise, en écrivant ces lignes, que certains parmi les lecteurs les plus jeunes n’auront sans doute aucune idée de ce à quoi je fais ici référence !).

Les pupitreurs étaient, autrefois, une pièce essentielle du fonctionnement des mainframes… c’était un autre temps, un autre monde (source https://www.agoravox.fr/actualites/technologies/article/les-premieres-annees-de-l-69147) !

Cela pourrait (à moyen terme) se révéler être un problème pour les nombreux projets Open Source en quête de contributeurs nombreux, compétents et bénévoles.

Des tendances contradictoires en apparence

Résumons-nous : le marché informatique est vraiment en train de changer de visage. Non seulement nous assistons à un “changement de la garde” radical mais, en plus, les pratiques sont également en train d’évoluer, en profondeur (l’Open Source se généralise enfin, au moins côté serveurs et infrastructures). L’Asie va jouer un rôle de plus en plus important et pas seulement dans le domaine de la production de masse.

Le passage d’un “achat de systèmes à décoffrer” à un “achat de services à mettre en œuvre” est en train de changer les compétences des personnels de DSI (et peu importe comment on appellera ce département à l’avenir au sein des organisations). L’informaticien est en train de devenir un peu moins technicien et un peu plus ouvert sur la satisfaction des utilisateurs qu’il est sensé servir (et ce n’est pas plus mal !). Toutes ces évolutions ne vont pas se faire en une nuit si sans heurts mais on voit que le passage à l’ambient computing (comme on commence à nommer la nouvelle omniprésence informatique) va bouleverser nos habitudes encore bien plus que lors des tournants précédents.

Hello, article intéressant qui décrit une évolution marquée et qui va surement s’accentuer. Si la logique technique et financière pousse les entreprise vers les solutions Cloud, il reste quelques paramètres qui pourraient venir perturber cette tendance. Pour l’heure, beaucoup de solutions migrent vers le Cloud mais la protection des données et le fait que la couche de base soit obscure laisse planer le doute sur la sécurité des données (sont elles réellement inaccessibles par autrui et qu’arriverait-il en cas de défaillance du Cloud?) Si ces scenarii sont peu envisageable ils ne sont pas exclus et une catastrophe d’envergure chez un hébergeur pourrait remettre en cause le modèle. La bonne solution est probablement entre les 2 mondes avec du Cloud hybride où les applications critiques restent hébergées sur infras traditionnelles et éventuellement secondées par du Cloud.

Une crise mondiale (improbable?) pourrait redistribuer les cartes et quand on voit l’impact d’un petit virus sur les approvisionnements mondiaux, il faut se garder de mettre tous ses oeufs dans le même panier.